Mientras más usable hagamos nuestro sitio web, más sencillo será posicionarnos bajo determinada palabra clave. La arquitectura de la información está tomando cada vez más importancia tanto del lado del usuario como del lado de los buscadores.

Mientras más usable hagamos nuestro sitio web, más sencillo será posicionarnos bajo determinada palabra clave. La arquitectura de la información está tomando cada vez más importancia tanto del lado del usuario como del lado de los buscadores.

Existen muchas formas de usar más usabilidad en nuestros diseños, pero a veces solo basta con ponernos un poco en la piel de nuestro posible navegante. Si pensamos en él nuestra tarea será más sencilla.

No hay duda de que uno de los temas que está dando mucho que hablar es el tema de la Arquitectura de la información en sitios web.

Los beneficios realmente son muy apreciables en lo que respecta a la funcionalidad o navegación web. Pero no solamente es el usuario navegante es el que se beneficia de sitios usables, los webmaster o generadores de recursos ven su tarea de actualización o incorporación de nuevos módulos como algo mucho más “liviano”, esto es así por el hecho de que la estructura usable posee una sencillez y lógica tal que permite expandir y hacer crecer en todos los sentidos a un sitio web.

Pero estamos hablando de que disponer de sitios usables nos ayuda notablemente en el posicionamiento. Aquí van algunas recomendaciones para aprovechar la forma en que interpreta google a los sitios que poseen buena usabilidad:

Sitios Web con código de programación Sencillo:

Google valora mucho un código simple y claro. Mientras menos código tenga una página mejor considerada por google será. Esto se ve de manera muy clara en los sitios que utilizan capas o etiquetas “div” en vez de tablas y código CSS para dar estilo a los textos y forma a cada tabla generada. La reducción del tamaño del código y la mejora considerable en la estructura de programación, junto con la reducción considerable en el consumo del ancho de banda del navegante hacen a nuestros sitios mucho más veloces y mejores vistos (por simplicidad de código) por google.

Inclusión de elementos Dinámicos:

Ya sea que utilizemos PHP, XHTML, ASP u otro lenguaje de programación, siempre será mejor que utilizar html puro. Esto es así por el hecho de que google valora mucho las tecnologías utilizadas en la creación de un sitio web. Además el uso de lenguajes dinámicos facilita la inclusión de nuevas secciones y permite jugar con variables o enlaces que de otra manera serían imposible lograr. El uso de includes () permite aplicar a todas las páginas de un sitio web un mismo bloque con enlaces, logrando optimizar considerablemente la usabilidad y por ende lograr una mejor conexión entre una página y otra, esto ayuda enormemente al posicioanamiento y detección de nuevas páginas.

Creación de un Mapa Web:

Muchos subestiman el uso de un claro mapa de sitio para ayudar a encontrar páginas que se encuentran perdidas o poseen un enlace generado desde una base de datos. Una gran ayuda para el posicionamiento web es la inclusión de un buen mapa de sitio con enlaces directos del tipo: http://www.tupagina.dom/pagina-a-vincular.php

Además de esto, el poseer un mapa de sitio ayuda al usuario y hace mucho más navegable un sitio web.

Mucho más textos, menos imágenes:

Uno de los principales errores que se comenten a la hora de diseñar un sitio “vistoso” es el abuso de los recursos gráfico para comunicar desde un sitio web.

Google otorga más relevancia a los enlaces “Textuales” y no tanto a los enlaces provenientes de imágenes. Esto es así por el hecho de que google valora mucho el texto que posee un enlace (Anchor Text) así, por ejemplo si queremos enlazar una seccion en nuestro sitio lo podremos hacer: “Venta de Computadoras” con un determindo enlace a una página interna de tipo: “tu_sitio.com/venta_de_computadoras.php”.

En cambio si utilizamos imágenes para enlazar nuestras páginas estaremos no aprovechando el recurso de “Anchor text” para dar relevancia a un enlace.

¿Significa esto que no son importante las imágenes que poseen un enlace? De ninguna manera, el uso de la Etiqueta “ALT” en cada imagen que posee un enlace es de gran ayuda para el posicionamiento.

Resumen:

Mientras más usable hagamos nuestro sitio web, más sencillo será posicionarnos bajo determinada palabra clave. La arquitectura de la información está tomando cada vez más importancia tanto del lado del usuario como del lado de los buscadores.

Existen muchas formas de usar más usabilidad en nuestros diseños, pero a veces solo basta con ponernos un poco en la piel de nuestro posible navegante. Si pensamos en él nuestra tarea será más sencilla.

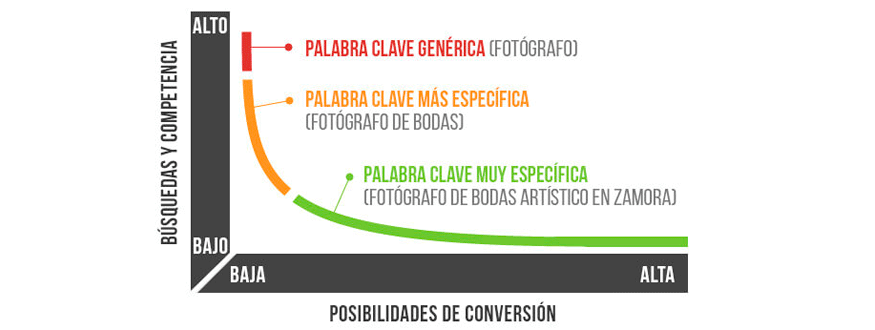

Para saber cómo empezar a posicionar un sitio web en Google desde el principio, es importante tener en cuenta ciertas estrategias, ya que es algo que ha despertado en las empresas el interés por la necesidad de estar en primer lugar en los buscadores como Google.

Para saber cómo empezar a posicionar un sitio web en Google desde el principio, es importante tener en cuenta ciertas estrategias, ya que es algo que ha despertado en las empresas el interés por la necesidad de estar en primer lugar en los buscadores como Google.

Antes de comenzar a dar de alta su sitio web en los distintos buscadores, le aconsejamos que escriba un pequeño documento (en Word Pad o Word, por ejemplo) con los siguientes datos:

Antes de comenzar a dar de alta su sitio web en los distintos buscadores, le aconsejamos que escriba un pequeño documento (en Word Pad o Word, por ejemplo) con los siguientes datos:

Mientras más usable hagamos nuestro sitio web, más sencillo será posicionarnos bajo determinada palabra clave. La arquitectura de la información está tomando cada vez más importancia tanto del lado del usuario como del lado de los buscadores.

Mientras más usable hagamos nuestro sitio web, más sencillo será posicionarnos bajo determinada palabra clave. La arquitectura de la información está tomando cada vez más importancia tanto del lado del usuario como del lado de los buscadores.

1. Los motores de búsqueda o arañas: La mayoría de los grandes buscadores internacionales que todos usamos y conocemos son de este tipo. Requieren muchos recursos para su funcionamiento. No están al alcance de cualquiera.

1. Los motores de búsqueda o arañas: La mayoría de los grandes buscadores internacionales que todos usamos y conocemos son de este tipo. Requieren muchos recursos para su funcionamiento. No están al alcance de cualquiera.